C’est alors qu’il effectuait un post doctorat en optique biomédicale aux États-Unis que Frédéric Bevilacqua a commencé à travailler avec des chorégraphes. Depuis, que ce soit par l’invention de nouveaux instruments de musique, des travaux sur la rééducation par le son ou une installation en collaboration avec un danseur, il se penche sur le mouvement. Entretien avec un homme passionné.

Votre parcours est pour le moins atypique. Pouvez-vous nous le résumer ?

J’ai toujours été intéressé par les arts et les sciences : j’ai commencé la musique très tôt et ai poursuivi des activités musicales pendant mes études scientifiques. Après avoir étudié la physique, j’ai été à Berkelee, une école de jazz, à Boston. J’ai fait ensuite un doctorat en optique biomédicale, puis un post doctorat aux États-Unis. J’ai toujours aimé les aspects interdisciplinaires (la technologie et la médecine, par exemple), mais c’est là-bas qu’est né mon intérêt pour l’art interactif. J’ai alors commencé à travailler sur la captation de mouvements, notamment avec des chorégraphes.

En 2003, on m’a offert un poste à l’Ircam, je suis donc retourné en France. Depuis trois ans, je suis le directeur de l’équipe de recherche en interactions musicales temps réel.

Si j’ai donc toujours eu de l’intérêt pour les arts et la science, ce n’est que récemment que j’ai pu mêler les deux.

Est-ce que c’est le fait d’être là-bas qui vous a permis de vous orienter vers des travaux plus multidisciplinaires ? Ce genre de recherches est-il plus présent aux États-Unis ?

Pour moi, ça a surtout été une question de rencontres. Cela dit, à Lausanne, à l’époque de mes études, il n’y avait pas encore de laboratoires interdisciplinaires. Mais je n’avais que vingt ans, ce qui m’intéressait en art, ce n’étaient pas encore les arts numériques.

Peut-on dire que la coopération entre les sciences et l’art soit une tendance récente ?

Non, mais le développement de tout ce qui est technologies numériques donne un terrain fertile. Il y a toujours eu ce genre de collaborations (par exemple entre l’électronique et l’art), mais aujourd’hui, comme ces recherches sont plus mainstream, ça crée de nouvelles opportunités.

Et plus de subventions ?

C’est une question assez large : ça varie beaucoup selon les pays. Ici, en France, il y a des fonds importants voués à la technologie sociale ou de l’information. C’est par ce type de thématique qu’on a des subventions pour nos sujets de recherche.

Comment est organisé l’Ircam ? N’il y a-t-il que des scientifiques ?

Il existe à l’Ircam trois départements : un département création qui produit des spectacles de musique ou d’arts vivants, un département recherche dans lequel les permanents sont des scientifiques et un département pédagogie qui offre notamment des cursus pour compositeurs. Il y a aussi des compositeurs en résidence. C’est un environnement très complet. Ça permet très facilement les contacts entre artistes et scientifiques, ce qui en fait un lieu assez unique.

Comment se passent en général les collaborations entre artistes et chercheurs ?

Il faut bien garder en tête que nos intérêts peuvent diverger. En effet, un scientifique et un artiste ont des contraintes différentes. Souvent au niveau du temps qu’ils peuvent consacrer à un projet, mais aussi quant au but de leur travail : celui du scientifique doit se solder par des publications et/ou des conférences alors que celui de l’artiste, par un spectacle. On assiste cependant à une reconnaissance de plus en plus grande au sein du monde scientifique de travaux qui débouchent sur des spectacles, des interactions avec les artistes. Personnellement, la valorisation de ce genre de travail me tient beaucoup à cœur.

Vous travaillez sur la conception de nouveaux instruments de musique. Pouvez-vous nous expliquer plus en détails de quoi il s’agit ?

J’ai d’abord travaillé sur la transformation d’instruments existants. Mes premiers travaux à l’Ircam ont porté sur le violon augmenté : les gestes du violoniste, principalement ses mouvements d’archet, sont captés puis interprétés par des logiciels pour un système de contrôle du son. L’analyse a lieu en temps réel : il y a un rapport direct entre le geste et son rendu sonore électronique. Mais il peut aussi y avoir une analyse des gestes, en comparaison d’une banque de données.

J’ai ensuite élaboré un nouvel instrument de musique, l’interface MO, qui a été présentée l’été passé au MoMa, à New York. C’est un instrument en tant que tel qui peut être utilisé avec la main, mais il est aussi modulaire : on peut l’utiliser avec des objets du quotidien. On en a fait une installation, Urban musical game, dans la ville : l’interface MO était placée dans un ballon. Celui-ci est important pour deux raisons : c’est un objet pour lequel tout le monde a déjà un vocabulaire gestuel (on peut le lancer en l’air, le faire rebondir par terre etc.) qu’on peut directement réutiliser : on transforme alors une connaissance en son. L’autre, c’est qu’on peut y jouer à plusieurs, on crée alors directement du lien. C’est intéressant en musique électronique parce que ça s’oppose aux instruments traditionnels, qu’on joue tout seul.

À partir de cette idée d’objet modulaire, un de mes doctorants a créé Mogees : c’est une interface qui transforme les surfaces des objets du quotidien (une table, par exemple) en instruments. Il y a un micro qui capte la surface de l’objet qui devient alors lui-même l’instrument. On est toujours dans la même logique, qu’il s’agisse d’un violon, d’un ballon ou d’une table : transformer des choses du quotidien, que l’instrumentiste connaît, en instruments augmentés. Les mêmes briques logicielles sont au cœur de toutes ces interfaces : on analyse un mouvement et on le transforme en son.

Comment fonctionnent ces différentes interfaces ?

Ce sont des systèmes de captation des mouvements et du toucher. Ensuite, ça passe dans un logiciel de reconnaissance des gestes puis un autre de synthèses interactives. On cherche la signature du geste, qui comprend notamment des notions de temps, d’accélération. On utilise ensuite cette signature pour transformer et synthétiser des sons.

Peut-on dire que vous vous employiez à définir le geste ?

Ce n’est pas un mot que j’aime parce qu’il est trop général, trop flou, mais finalement, je l’utilise souvent, dans un sens très large. Ça englobe tout ce qui est mouvement, le toucher aussi. Selon les contextes, on y rajoute ou non une notion de sens, de communication. Dans des cas concrets comme la musique et la danse, ça devient plus explicite : par exemple, les gestes de l’archet sont des choses définies que tous les compositeurs et joueurs connaissent.

Notre banque de données est une autre des approches possibles pour analyser les gestes. On confronte des gestes les uns aux autres pour essayer de comprendre leur vocabulaire.

C’est un problème complexe : comment transmet-on un vocabulaire gestuel ? Cette question est centrale dans la danse, par exemple. On peut les filmer, mais souvent ça se passe par imitation du type de geste.

En plus de vous vous être penché sur des interfaces musicales, vous avez participé à des performances, notamment avec le danseur et chorégraphe Richard Siegal.

En 2006, alors que je travaillais sur un système de reconnaissance de gestes, j’ai rencontré Richard Siegal, qui venait de mettre au point If/then, une méthode chorégraphique définie par des actions et les liens de causalité entre celles-ci. C’était donc un travail à partir d’un système de règles et de mouvements complémentaires : on fixe au préalable des règles, une grammaire gestuelle, et puis on part en improvisation ou on fixe ce qu’on a trouvé. On s’est dit que ce serait intéressant de mélanger nos recherches respectives. Ce travail en parallèle a donné lieu à une installation, If/then Installed et une performance, Homo ludens.

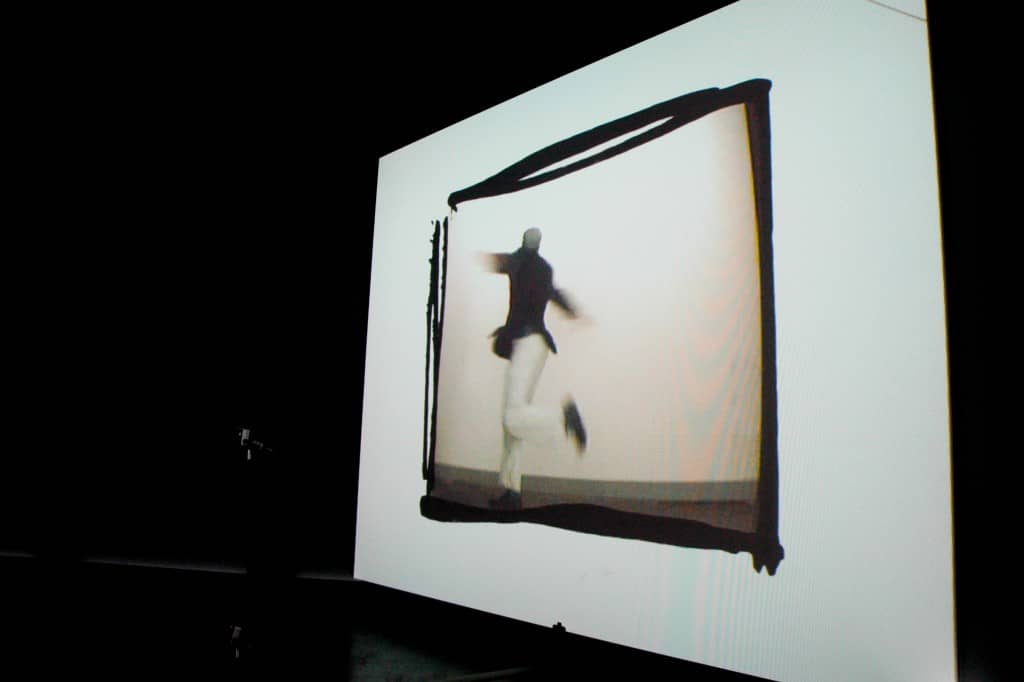

If/then, Installed [les photos de cet article, ndlr] est une installation lors de laquelle le spectateur est face à un écran qui l’invite à faire un certain mouvement qu’il voit en boucle. S’il le fait, il voit Richard Siegal se synchroniser avec lui dans le même mouvement, comme devant un miroir. Le jeu est donc de suivre pour ensuite être suivi. Tout cela est enregistré et l’image du spectateur se substitue ensuite à celle du danseur, ce qui crée un décalage entre le geste du professionnel et celui du profane. On a ensuite un système de chorégraphie : après chaque vidéo, différents choix gestuels s’offrent au spectateur qui navigue alors dans une chorégraphie. Avec l’Ircam, on a développé le système de reconnaissance de gestes qui permet de synchroniser immédiatement des gestes et une vidéo, puis on y a rajouté une caméra. C’est ironique : finalement, c’est devenu une installation sans son, uniquement visuelle.

Pour Homo ludens, la performance, on retrouve au début du spectacle Richard Siegal entre deux écrans vidéo sur lesquels il y a sa silhouette. Il improvise à partir de plusieurs mouvements préétablis et, toujours grâce à ce même système de capteurs qui reconnaissent les gestes, il s’amuse avec le système, danse avec ses silhouettes.

Vos recherches restent-elles confinées dans le milieu scientifique ou vos interfaces sont-elles utilisées par des musiciens ?

Le violon augmenté a été utilisé dans plusieurs contextes différents. Florence Baschet, qui est compositrice, l’a utilisé aussi bien dans le contexte d’un violon seul que dans celui d’un quatuor. Mari Kimura, violoniste, compositrice et performeuse, l’a utilisé avec une approche fort différente.

C’est très positif pour nous, de voir que le même outil donne des choses différentes. Un des dangers de la technologie est de ne produire qu’une seule esthétique. Je vois ici avec joie qu’elle peut être incorporée différemment dans l’univers de plusieurs artistes.

Dans quels domaines vos recherches sont-elles utilisées ?

Selon nos diverses collaborations, dans beaucoup de domaines différents : l’art, la rééducation, des installations, le jeu ou encore un cadre pédagogique. C’est souvent nos étudiants qui continuent à développer des utilisations des résultats de mes recherches dans des domaines différents. C’est un travail collectif.

Un de mes doctorants a, par exemple, développé un système qui permet de contrôler la vitesse d’un fichier son ; un autre a travaillé sur les gestes du chef d’orchestre : si l’orchestre se synchronise à lui, ça lui permet de jouer en duo avec un autre orchestre.

Avez-vous envisagé des collaborations avec d’autres domaines artistiques que la musique ou la danse ?

Pas encore ! On va peut-être entamer une recherche avec le théâtre. On veut voir comment les technologies que nous développons peuvent s’appliquer à la voix. Si on regarde les choses dans une perspective très large, les sons, dont la voix, peuvent être considérés comme des gestes. Notre système peut s’utiliser avec un matériel sonore et plus de capteurs.

Beaucoup de nos projets se développent en collaboration avec l’Ircam, qui s’ouvre de plus en plus au spectacle vivant, donc il y a de bonnes chances pour qu’on puisse se diriger vers une collaboration avec du théâtre, beaucoup plus que vers les arts graphiques, par exemple.

Quels sont vos projets en cours ?

Pour le moment, nous travaillons sur la question de l’apprentissage du mouvement au sens moteur. On cherche comment aider la rééducation gestuelle avec un retour sonore. On est ici dans le milieu du médical. Je me retrouve toujours dans cette question de la formalisation, de la vision de ce qu’on fait, que j’avais étudiée jusque là dans le travail artistique.

Concomitamment, nous avons entamé un travail exploratoire de recherche avec Thierry De Mey qui a instauré la notion de « mouvement remarquable ». On explore les différents types de mouvements et leur représentation. Il est ici question de la qualité du mouvement. On peut décrire la manière dont on effectue le mouvement, mais c’est toujours en fin de compte le mouvement en lui-même qui est remarquable.

Frédéric Bevilacqua est né à Lausanne (Suisse). Après avoir suivi des études scientifiques et musicales, il obtient un diplôme de physique (1991) et passe un an à étudier la musique au Berklee College of Music à Boston (1992-1993) avant de se pencher sur un doctorat en optique biomédicale de l’École polytechnique fédérale de Lausanne (1998). Il effectue ensuite de nombreuses années de post doctorat au Beckman Laser Institute and Medical Clinic (Université de Californie). Depuis octobre 2003, il est chargé de recherches sur la captation et l’analyse du geste à l’Ircam (Institut de Recherche et Coordination Acoustique/Musique, Paris) dans l’équipe applications musicales temps réel, et participe au pôle de recherches sur les technologies pour le spectacle.

Photos : Hillary Goidell